Intelligente Bild- und Videoanalyse

In der Bildverarbeitung kommen in den letzten Jahren zunehmend Verfahren des maschinellen Lernens zum Einsatz. Besonders leistungsfähig haben sich dabei Deep Convolutional Neural Networks (tiefe CNN) erwiesen, die sich hervorragend für die Klassifizierung und Erkennung von Bildinhalten eignen. Zu den ersten großen Durchbrüchen zählte die zuverlässige Erkennung von handgeschriebenen Postleitzahlen, was als Meilenstein in der automatisierten Texterkennung galt. Später folgten weitere bedeutende Fortschritte, etwa bei der Gesichtserkennung, der automatischen Erfassung von Kfz-Kennzeichen, der Identifikation von Personen und Verkehrsschildern sowie der Detektion von Hindernissen und deren Position im Raum.

Systeme der intelligenten Bild- und Videoanalyse finden längst auch außerhalb von Mobilität und Sicherheit breite Anwendung. In der Lebensmittelindustrie dienen sie der Qualitätskontrolle, in der Medizin unterstützen sie die frühzeitige Diagnose von Hautkrankheiten und Tumoren. Auch in der Landwirtschaft ermöglichen sie die Erkennung von Unkraut, Pflanzenkrankheiten und Schädlingen für effizienteren Ressourceneinsatz. Im Umwelt- und Klimaschutz kommen sie unter anderem bei Waldbrand-Früherkennungssystemen zum Einsatz, um Brände schneller zu entdecken und Menschen sowie Natur besser zu schützen. Im Bereich Recycling kann diese neue Technologie eingesetzt werden, um Kunststoffe zuverlässig und effizient zu erkennen und somit eine Wiederverwendung (Recycling) zu ermöglichen.

| Contact |

| Katja Kossira, M.Sc. |

| E-Mail: katja.kossira@fau.de |

| Link to person |

| PD Dr.-Ing. habil. Jürgen Seiler |

| E-Mail: juergen.seiler@fau.de |

| Link zur Person |

Einsatz von Methoden der der intelligenten Bild- und Videoanalyse im Bereich Recycling

Die steigende Relevanz des Themas Umwelt- und Klimaschutz wirkt sich auf viele Bereiche unseres Lebens aus: Strände im Urlaub sind übersät mit Einweg- Plastikflaschen und im Ozean treibt ein riesiger Müllstrudel. Die Temperaturen steigen, trotzdem findet man im Supermarkt kaum etwas, das nicht in Kunststoff verpackt ist. Diese Mengen an Müll werden aktuell zu 67 % thermisch verwertet, d.h. verbrannt, der Wirkungsgrad dabei beträgt allerdings lediglich 30 %, zusätzlich wird dabei viel CO2 ausgestoßen (Quelle: Plastikatlas 20191). Da beim Recycling der Wirkungsgrad mit 85 % deutlich höher liegt und zusätzlich weniger CO2 ausgestoßen wird, ist es wichtig, effiziente und günstige Methoden zu schaffen, Kunststoffe einwandfrei zu klassifizieren, um sie dem Wiederverwendungsprozess zuzuführen.

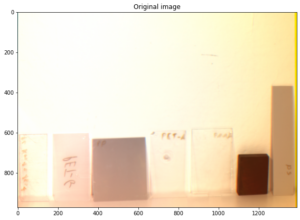

Zur Unterstützung dieser Entwicklung soll ein neuer Ansatz erforscht werden, der mittels intelligenter Bild- und Videoanalyse unter Zuhilfenahme von KI entscheidet, welcher Kunststoffart die Probe angehört. Grundlage hierfür war die Feststellung, dass die Kohlenstoffketten der Kunststoffe das Licht bei unterschiedlichen Wellenlängen im infraroten Bereich unterschiedlich stark reflektieren, wodurch sich verschiedene Farben für charakteristische Wellenlängen ergeben. Dies ist beispielhaft in der folgenden Abbildung dargestellt (links: originale Darstellung, rechts: Überlagerung von Bilder aufgenommen mit Filtern der Wellenlängen 850nm, 1000nm und 1150nm).

Um künftig die Kunststoffe automatisiert zu erkennen, wird das multispektrale Kamera Array zur Bildgebung (CAMSI) weiterentwickelt und den Bedürfnissen angepasst. Die spektralen Fingerabdrücke der verschiedenen Kunststoffklassen werden ermittelt und im Anschluss zum Trainieren eines Modells verwendet. Außerdem wird eine Entscheidungsmatrix erstellt, die aufgrund von signifikanten Peaks der Spektren die optimale Filterwahl bestimmt. Hiermit erfolgt dann eine eindeutige Klassifikation und der Wertstoff kann dem Recyclingprozess zugeführt werden. Eingesetzt werden soll die neue Methode beispielsweise in Pfandautomaten oder an Sortieranlagen von Wertstoffhöfen.

Im Herbst 2024 wurde diese Forschung mit dem Nachhaltigkeitspreis der FAU ausgezeichnet (weitere Informationen).

1 https://www.bund.net/fileadmin/user_upload_bund/publikationen/chemie/chemie_plastikatlas_2019.pdf

| Contact |

| Marina Ritthaler, M.Sc. |

| E-Mail: marina.ritthaler@fau.de |

| Link to person |

| PD Dr.-Ing. habil. Jürgen Seiler |

| E-Mail: juergen.seiler@fau.de |

| Link zur Person |

Punktwolken-Upsampling mithilfe Frequenz-Selektiver Methoden

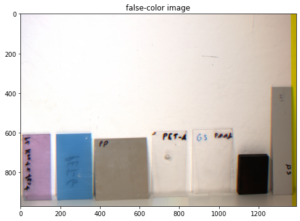

Mit der zunehmenden Verfügbarkeit von 3D-Sensoren wie LiDAR werden dreidimensionale Daten häufig als Punktwolken dargestellt. Punktwolken bestehen aus ungeordneten einzelnen Punkten in einem dreidimensionalen Raum. Zusätzlich zu ihren kartesischen Koordinaten können sie Attribute besitzen. Diese Attribute können Farbe, Bewegungsvektoren, Textur, Reflexionseigenschaften oder andere Informationen sein. Die Erfassung hochauflösender Punktwolken ist kostspielig. Daher sind sie häufig spärlich, verrauscht und ungleichmäßig verteilt. Die Aufgabe des Upsamplings besteht somit darin, eine dichte, vollständige und uniforme Punktwolke zu erzeugen.

In unserem Ansatz möchten wir die Auflösung mithilfe des frequenzselektiven Prinzips erhöhen. Dabei verwenden wir die Annahme eines spärlichen Frequenzbereichs, der in Form gewichteter Basisfunktionen dargestellt werden kann.

| Contact |

| Felix Deichsel, M.Sc. |

| E-Mail: felix.deichsel@fau.de |

| Link to person |

| PD Dr.-Ing. habil. Jürgen Seiler |

| E-Mail: juergen.seiler@fau.de |

| Link zur Person |

Prädiktive Wartung für Verteilte Systeme

Im Kontext von Industrie 4.0 bezeichnet prädiktive Wartung die kontinuierliche Erfassung und Analyse von Mess- und Sensordaten, um den Zustand von Maschinen vorherzusagen und Wartungsmaßnahmen bedarfsgerecht sowie vorausschauend zu planen. Dadurch lassen sich ungeplante Stillstände reduzieren, die Effizienz steigern und die Lebensdauer der Maschinen verlängern, was sowohl ökonomische als auch ökologische Vorteile mit sich bringt.

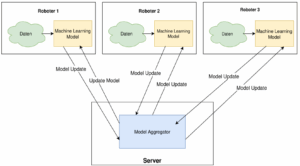

Der industrielle Einsatz prädiktiver Wartung beschränkt sich derzeit überwiegend auf die Überwachung einzelner Maschinen. Im Rahmen des Projekts „Lernende prädiktive Wartung von vernetzten Geräteflotten“ wird hingegen ein flottenweites prädiktives Wartungssystem entwickelt. Ziel ist es, den Wartungsbedarf einzelner Maschinen mit höherer Genauigkeit zu bestimmen, indem die Daten aller innerhalb einer Flotte vernetzten Geräte gemeinsam ausgewertet werden.

Hierzu kommen unterschiedliche Methoden des maschinellen Lernens und der künstlichen Intelligenz zum Einsatz. Der Schwerpunkt der Forschungsarbeit liegt insbesondere auf der Anomaliedetektion zur frühzeitigen Erkennung von Abweichungen im Maschinenverhalten sowie auf Federated Learning, um ein gemeinsames, leistungsfähiges Modell über mehrere Geräte hinweg zu trainieren, ohne sensible Betriebsdaten zentral zusammenführen zu müssen.

Eingebettete Wahrnehmung für autonome Fahrzeuge

| Contact |

| Maximiliane Gruber, M. Sc. |

| E-Mail: maximiliane.gruber@fau.de |

| Link zur Person |

| PD Dr.-Ing. habil. Jürgen Seiler |

| E-Mail: juergen.seiler@fau.de |

| Link zur Person |

Das Hauptziel der eingebetteten Wahrnehmung ist die Entwicklung eines datengestriebenen Frameworks, das die Objekterkennung in Straßendaten ermöglicht und so den Fortschritt im autonomen Fahren vorantreibt. Das Hardwaresystem umfasst mehrere Kameras und LiDAR-Sensoren, während das Softwaresystem sowohl aus einer Offline- als auch einer Online-Wahrnehmungskomponente besteht. Die Online-Komponente ist darauf ausgelegt, präzise Ergebnisse in Echtzeit zu liefern und gleichzeitig die begrenzten Rechenressourcen während der Fahrt effektiv zu nutzen. Die Offline-Komponente hingegen arbeitet unabhängig von denselben Daten, sobald die Aufzeichnungen abgeschlossen sind. Es profitiert von umfangreicheren Rechenressourcen und ermöglicht die Ausführung hochkomplexer Algorithmen. Dadurch werden zuverlässigere Ergebnisse erwartet. Mit einem solchen System können große Referenzdatensätze über verschiedene Verkehrs- und Wetterbedingungen generiert werden.

Die Entwicklung des Frameworks zur eingebetteten Wahrnehmung umfasst verschiedene Herausforderungen im Bereich der Signalverarbeitung, darunter unter anderem die Kalibrierung von Sensoren, Datenkomprimierung, Analyse und Fusion multimodaler Daten, Datenaugmentierung und die Entwicklung von Wahrnehmungsalgorithmen. Die Schwerpunkte unserer Forschung lassen sich grob in folgende Bereiche gliedern:

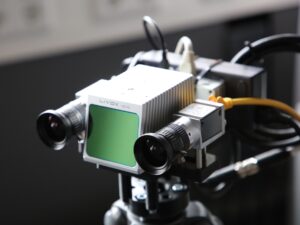

- Selbstkalibrierung der LiDAR-Kamera Um den Anforderungen durch die vielfältigen Betriebsbedingungen gerecht zu werden und heuristische Algorithmen zu vermeiden, schlagen wir eine auf tiefem Lernen basierende Methode zur Selbstkalibrierung vor. Ziel dieser Methode ist es, gleichzeitig eine intrinsische Kalibrierung des Kamerasensors und eine extrinsische Kalibrierung der LiDAR-Kamerakonfiguration durchzuführen.

- LiDAR-Punktwolkencodierung Effiziente Codierungsalgorithmen sind entscheidend für die Verarbeitung der großen Datenmengen, die mit LiDAR-Sensoren aufgenommen werden und gespeichert oder übertragen werden sollen. Kleinere Dateigrößen reduzieren nicht nur die Arbeitsspeicher- und Datenspeicherkosten, sondern ermöglichen auch einen schnelleren Informationsaustausch, wodurch die Gesamtlatenz des Wahrnehmungssystems verringert wird. Da diese Signale hauptsächlich nachgelagerten Wahrnehmungsaufgaben wie der Objekterkennung dienen, geht unsere Forschung über traditionelle Qualitätsmetriken wie PSNR hinaus. Wir entwickeln Codierungsalgorithmen, die auch den Einfluss der LiDAR-Punktwolkencodierung auf die Erkennungsgenauigkeit in modernen Wahrnehmungsalgorithmen berücksichtigen.

|

Abb. 1: Demonstratoraufbau bestehend aus Stereokamera und LiDAR-Sensor.

|

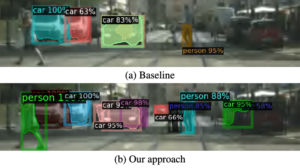

Abb. 2: Leistungsverbesserung durch unsere Methoden zum Lernen von Bildstörungen bei Bildern, die durch JPEG2000-Kodierung verzerrt wurden.

|

|

|

- Lernen von Bildstörungen zur Domänenadaption Da datengetriebene Methoden eine bestimmte Aufgabe aus annotierten Datenproben erlernen, hängen solche Methoden stark von der Qualität der Trainingsdaten ab. Das heißt die Trainingsdaten müssen den Daten, die während der Anwendung und des Tests auftreten, ausreichend ähneln. In der Praxis können unbekannte Verzerrungen jedoch zu einer Diskrepanz zwischen Trainings- und Testdaten führen (engl. domain gap), was die Leistung eines Bildverarbeitungssystems beeinträchtigt. Beispiele für solche unbekannten Verzerrungen, die in Bilddaten auftreten, sind Unschärfe, Rauschen und Codierung. Diese Verzerrungen unterscheiden sich beispielsweise für verschiedene Kamerasysteme. In Abb. 2a wird beispielhaft der Leistungsabfall für JPEG2000-codierte Testdaten veranschaulicht, wenn die Trainingsdaten keine derartigen Verzerrungen enthielten. Um dem Leistungsabfall von Bildverarbeitungssystemen in solchen Fällen zu begegnen, erforschen wir Methoden zum Lernen der oben genannten unbekannten Bildverzerrungen. Die erlernten Bildverzerrungen werden dann auf sauberen Daten emuliert, die als zusätzliche Trainingsdaten zur Verbesserung der Leistung von Bildverarbeitungssystemen dienen. In unseren Arbeiten betrachten wir maschinelle Bildverarbeitungssysteme als Black Box und entwickeln allgemeine Methoden, die für verschiedene Aufgaben eingesetzt werden können. Dieser Ansatz wird auch als Domänenanpassung auf Pixelebene (engl. pixel-level domain adaptation) bezeichnet. In Abb. 2b ist die Verbesserung der Objekterkennung, bei der Verwendung unserer Methode dargestellt.

- Fahrspurerkennung Die Fahrspurerkennung ist eine entscheidende Komponente für die sichere Navigation autonomer Fahrzeuge. Unsere Forschung konzentriert sich auf die Entwicklung eines auf einem neuronalen Netzwerk basierenden Modells, das fusionierte Merkmale von LiDAR und monokularen Kamerasignalen nutzt, um ein 3D-Profil der Straße zu erstellen. Die Spurerkennungsfunktionen unseres Modells sind robust gegenüber Straßengefälle und ermöglichen eine präzise Tiefenschätzung.

- Objekterkennung und Objektverfolgung Zur Objekterkennung gehört die Identifizierung und Lokalisierung von Verkehrsteilnehmern und Verkehrszeichen innerhalb eines von den Fahrzeugsensoren erfassten Rahmens. Die Objektverfolgung verbessert die Wahrnehmung durch die Verknüpfung identischer Objekte über mehrere Frames hinweg und ermöglicht die Bewegungsschätzung für dynamische Einheiten wie Fußgänger und Fahrzeuge. Bei der 3D-Mehrobjektverfolgungsaufgabe werden üblicherweise zwei Ansätze verwendet. Der erste Ansatz verwendet ein durchgängig trainierbares Objektverfolgungssystem für eine Bildsequenz. Der zweite Ansatz besteht darin, für jedes Bild einzeln einen 3D-Objektdetektor zu verwenden und anschließend mithilfe eines Kalman-Filters und des ungarischen Algorithmus eine Zuordnung vorzunehmen. Unsere Forschung untersucht beide Ansätze und optimiert sie weiter, um den Herausforderungen in Bezug auf Geschwindigkeit und Genauigkeit in unseren Online- und Offline-Verarbeitungspipelines gerecht zu werden.

| Contact |

| PD Dr.-Ing. habil. Jürgen Seiler |

| E-Mail: juergen.seiler@fau.de |

| Link zur Person |

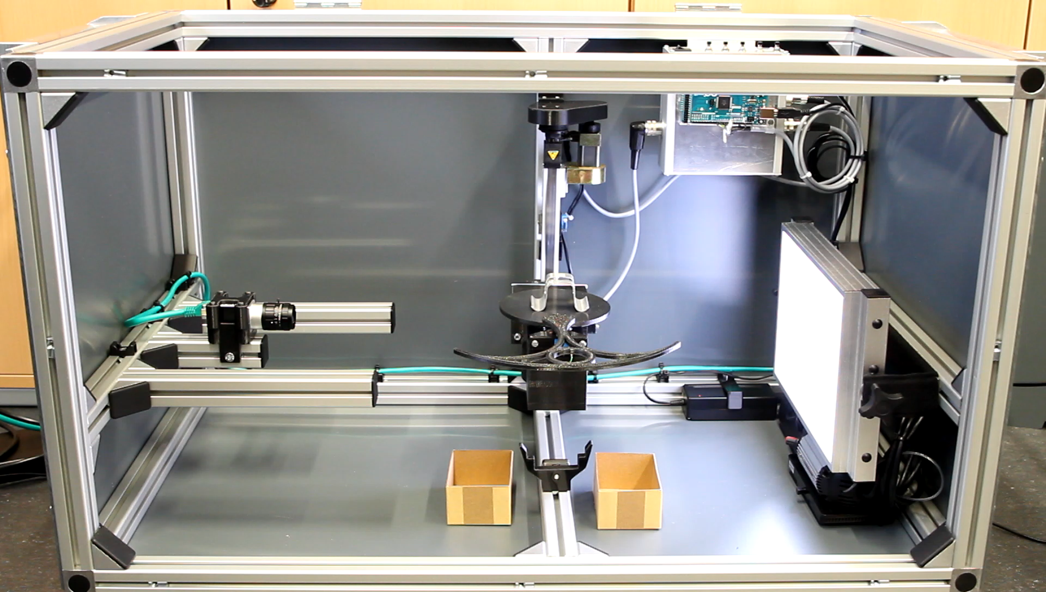

Künstliche Intelligenz für die Qualitätssicherung

Der steigende Grad der Automatisierung wirkt sich auf alle Bereiche unseres Lebens aus. Ein Themenfeld, das diesem Wandel jedoch besonders unterliegt, ist die maschinelle Produktion. Moderne Fertigungsstraßen arbeiten bereits jetzt weitgehend ohne menschliche Eingriffe, durch die bevorstehenden Änderung im Rahmen von Industrie 4.0 wird dieses Phänomen jedoch noch deutlich ausgeprägter werden. Um die Qualität der so produzierten Werkstücke garantieren zu können, ist es notwendig eine abschließende Sichtkontrolle durchzuführen. Aktuell wird diese in vielen Bereichen immer noch manuell durchgeführt, da es sich dabei jedoch um eine monotone und anstrengende Arbeit handelt, wird auch hierfür nach einer automatisierten Lösung gesucht.

Es existieren bereits seit einigen Jahren solch automatische optische Prüfsysteme, diese bedienen sich bisher jedoch klassischen Bildverarbeitungsmethoden, die es erforderlich machen vor Beginn der Prüfung die jeweiligen Toleranzbereiche und Prüfkriterien für das aktuelle Werkstück festzulegen. Gerade im Kontext von Industrie 4.0 mit häufig wechselnden Prüfaufgaben und Kleinserien ist dieses Vorgehen zunehmend ineffizient. Alternativ hierzu soll ein neuer Ansatz entwickelt werden, der mittels maschinellen Lernens entscheidet, welche Werkstücke in Ordnung sind, und welche Werkstücke fehlerhaft sind. Das typische Vorgehen zur Lösung dieses Problems wäre, eine Vielzahl an Aufnahmen von einwandfreien und beschädigten Werkstücken zu nutzen und diese Aufnahmen dann zum Training eines neuronalen Netzes zu verwenden. Hierbei besteht jedoch das große Problem, dass eine entsprechend große Anzahl an Werkstücken erst einmal erstellt werden muss. Weiterhin müssen genügend fehlerhafte Werkstücke enthalten sein, um ein verlässliches Training zu gewährleisten.

Gerade in Hinblick auf eine schnelle Anpassbarkeit der Produktion und der individuellen Herstellung von Werkstücken ist dieses Vorgehen nicht geeignet. Um die Herstellung von Werkstücken und anschließende Begutachtung zur Erstellung von Trainingsdaten für das neuronale Netz zu vermeiden, wird hier ein neuer Ansatz verfolgt. Hierbei werden die Trainingsdaten nicht mit einer Kamera aufgenommen, sondern simuliert. Das bedeutet, ausgehend von einem Modell des zu produzierenden Werkstücks werden die Bilder simuliert, die später in der Produktion während der Qualitätsprüfung aufgenommen werden. Das damit trainierte neuronale Netz wird anschließend auf tatsächlichen Aufnahmen der zu prüfenden Werkstücke angewendet. Hiermit erfolgt dann eine Klassifikation nach fehlerfreien und fehlerhaften Werkstücken.

Spektrale Rekonstruktion

| Contact |

| PD Dr.-Ing. habil. Jürgen Seiler |

| E-Mail: juergen.seiler@fau.de |

| Link zur Person |

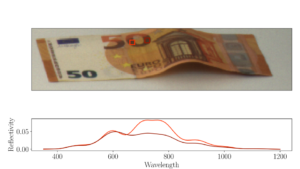

Die Benutzung von multi- und hyperspektalen Aufnahmesystemen (siehe oben) führt zu weiteren Herausforderungen. Für eine Vielzahl and Anwendungen sind die reflektierten Spektren essenzielle Informationen, um klassifizieren zu können. Demnach ist die Rekonstruktion der emittierten Spektren aus multispektralen Aufnahmen eine fundamentale Berechnung. Diese Berechnung beinhaltet diverse Fragestellungen. Üblicherweise werden mehr Variablen rekonstruiert als Beobachtungen zur Verfügung stehen. Um das zu lösen, muss man Vorkenntnisse über Spektren einarbeiten. Außerdem sind multispektrale Videos, z.B. stelle man sich eine Drohne, die über Felder fliegt und die Gesundheit von Pflanzen misst, vor, typischerweise stark verrauscht, da jedes einzelne Bild nur eine begrenzte Belichtungszeit hat. Dementsprechend müssen spektrale Rekonstruktionstechniken entwickelt werden, die robust gegenüber verrauschten Bildern arbeiten. Die Anwendungen von so einer Technik sind extrem vielseitig. Zum Beispiel können verschiedene Plastikarten unterschieden werden, Medikamentenfälschungen erkannt werden, oder Sicherheitsmerkmale auf Geldscheinen analysiert werden:

| Rekonstruierte Spektren (die Farbe der Marker entspricht der Farbe der Spektren) | Rekonstruierte Bilder an bestimmten Wellenlängen |

|

|